内容来自ChatGPT4

答:Java中的引用类型是管理内存和垃圾回收的关键工具。在Java中,有四种类型的引用:强引用、软引用、弱引用和幻引用。每种引用类型都有其特定的使用场景和垃圾回收行为。

... ➦深刻怀疑IDEA在硬卷,滚动条的highlight提示越来越多了,颜色丰富的像彩虹,还很密集。这样根本就达不到highlight的目的了。

... ➦2022年并没有做年终总结,我想给2022年的关键词是“质变”,有几方面的意味:

而2023年,则没有这种质变的意味了,我的关键词是“落地”,描述的是:

前几天Github告诉我说You're now in the CodeSpaces beta,今天体验了下,又发现了一个白嫖计算资源的机会啊。

... ➦2023-12-11更新:目前Codespaces已经正式发布,我个人将Rust开发全部移到了Codespaces上,下文有我的详细配置,欢迎阅读。收费策略上,目前个人免费账户每月有120小时的Core hours per month额度,这就意味着每月可以白嫖2C8G的机器60小时,或4C16G机器30小时。

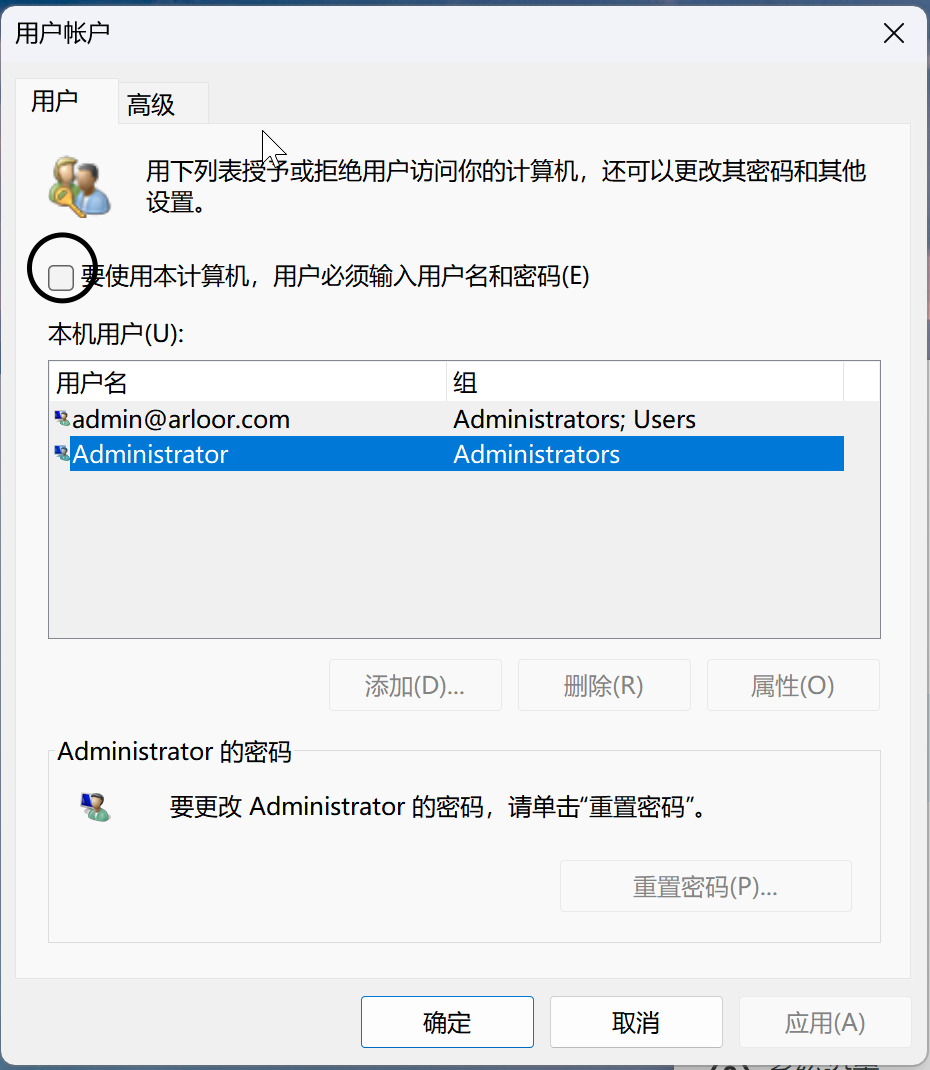

reg ADD "HKLM\SOFTWARE\Microsoft\Windows NT\CurrentVersion\PasswordLess\Device" /v DevicePasswordLessBuildVersion /t REG_DWORD /d 0 /f

netplwiz ,并取消勾选

Async Profile是Java应用profiling的强大工具,可以方便地输出火焰图html或者jfr格式给Java Mission Control查看,这里记录下如何使用。

... ➦Hbase会为每一个region server创建一个IPC client线程来做读写操作,并且该线程空闲两分钟就会被关闭。并且Hbase使用Java NIO的Socket Channel和HeapByteBuffer来做读写操作。由于JDK内部机制的问题,会导致直接内存泄漏,下面介绍所谓的内部机制来剖析根因。

本文首先介绍Springboot的单数据源配置方式,并介绍其中的Springboot自动装配细节;其次介绍如何配置多数据源。

... ➦